Toma nota. En los últimos años, el buscador de Google ha ido avanzando en tres direcciones: 1) disimular la publicidad entre los resultados de búsqueda, 2) responder a nuestras preguntas sin que tengamos que salir de Google y 3) mostrar contenido más relevante personalizando los resultados, según recoge el autor original de este artículo Matías S. Zavia en gizmodo y comparte Francisco Lorenson para Periodista Digital.

Una forma que tiene Google de mostrar resultados más relevantes es consultar nuestra ubicación. Cuando buscamos “Córdoba” en Google, los resultados cambian dependiendo de si nos encontramos en Argentina, en España o en México. Pero saberlo todo sobre nosotros no es suficiente para entender lo que estamos buscando.

Aquí es donde entra en juego la nueva herramienta de Google, conocida como BERT (Bidirectional Encoder Representations from Transformers). BERT es una red neuronal de código abierto entrenada por Google para procesar de forma más efectiva el lenguaje natural, es decir, la manera en que nos expresamos.

“Con los últimos avances de nuestro equipo de investigadores en la ciencia de la comprensión del lenguaje, que ha sido posible gracias al aprendizaje automático, estamos mejorando significativamente la forma en que entendemos las consultas”, escribió Pandu Nayak, vicepresidente de Google Search, en un comunicado. “Esto representa nuestro mayor avance en los últimos cinco años, y uno de los mayores avances en la historia del buscador”.

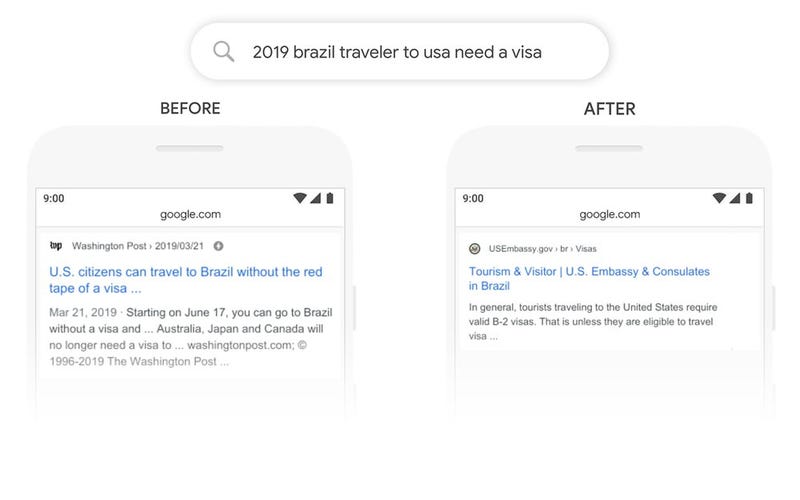

Un ejemplo real. Antes de BERT, la búsqueda “2019 viajar de Brasil a Estados Unidos hace falta visado” devolvía un artículo del Washington Post sobre viajar a Brasil desde Estados Unidos; el buscador no entendía la importancia de la preposición “a” en la frase. Con BERT, el buscador devuelve como primer resultado la web de la embajada estadounidense en Brasil; en concreto, una página sobre visados para turistas brasileños:

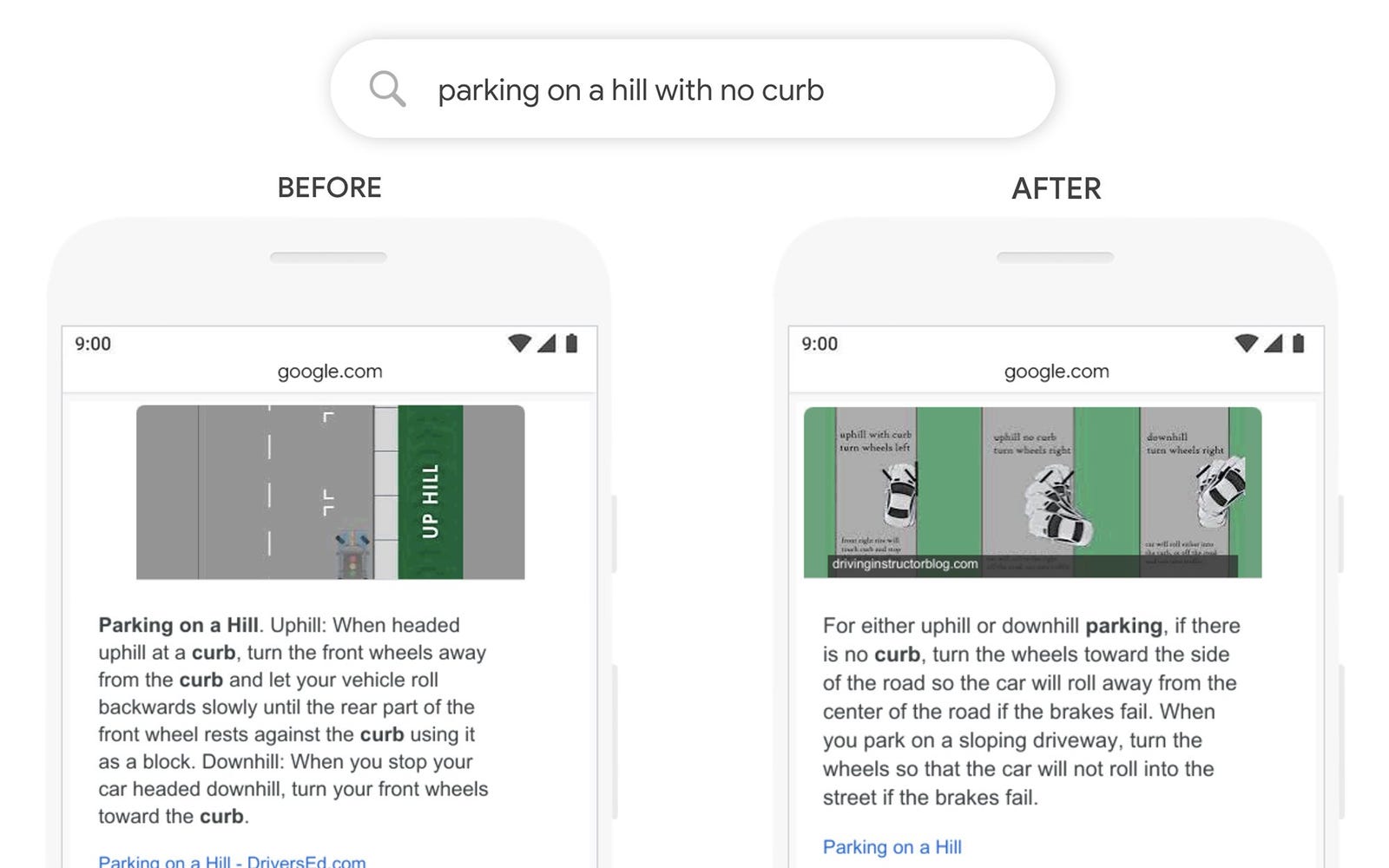

Ocurre lo mismo con los adverbios. Antes de BERT, la búsqueda “aparcar en una cuesta si no hay bordillo” obviaba la importancia de la palabra “no” y devolvía un resultado sobre aparcar en una cuesta con bordillo. Con BERT, el algoritmo comprende mejor la frase y cambia el resultado a un tutorial más relevante para el usuario:

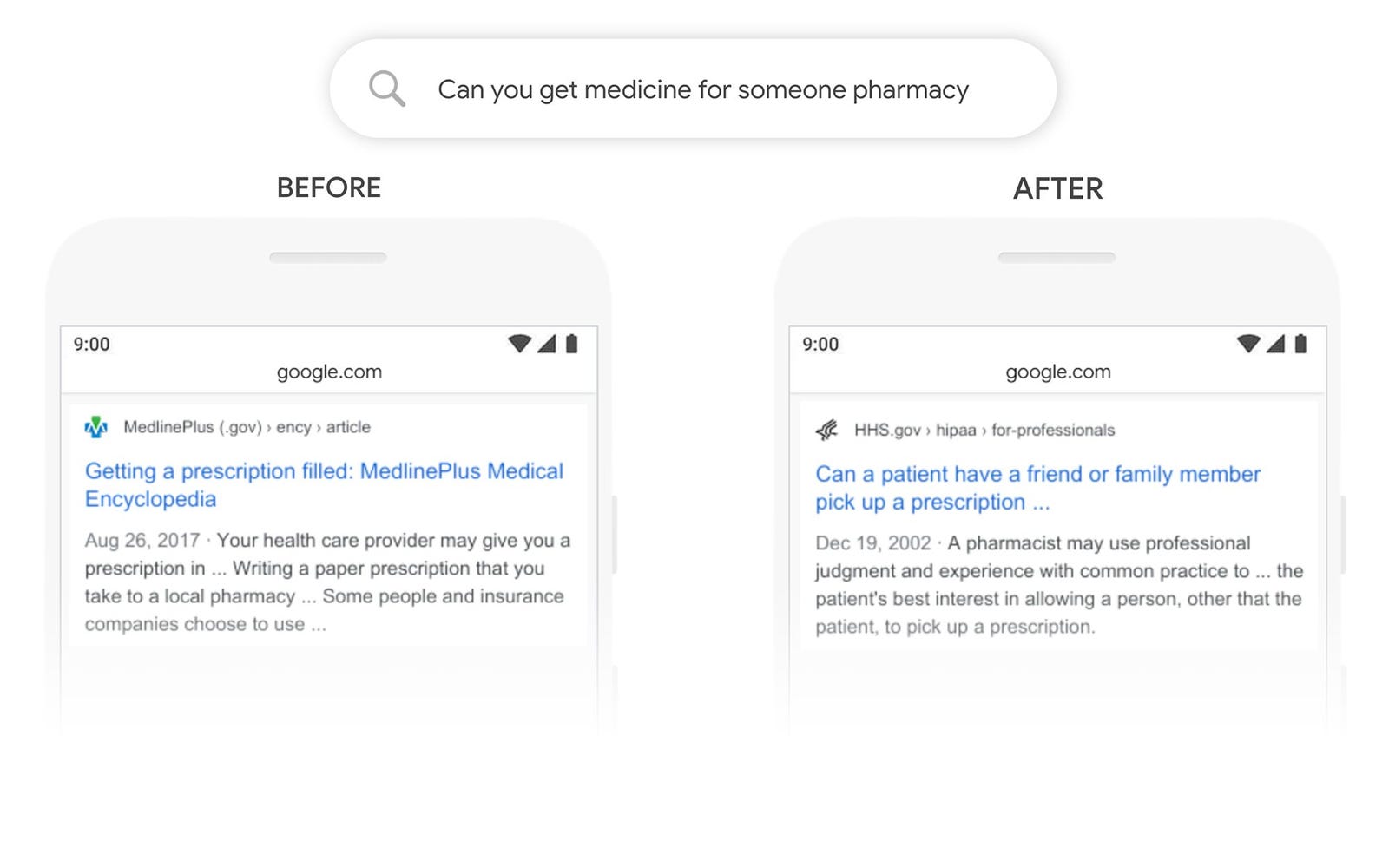

BERT nos anima a dejar de pensar en “palabras clave” y formular preguntas a Google como las que haríamos a una persona. Por ejemplo: antes de BERT, la búsqueda “¿puedes comprar un medicamento para otra persona en la farmacia?” no entendía la importancia de “para otra persona” en la frase, así que devolvía resultados generales sobre medicamentos y farmacias. Con BERT, la pregunta queda contestada en el primer resultado, una página del gobierno:

BERT es un cambio importante para el buscador, pero no es ninguna novedad dentro de Google. La compañía lleva años mejorando sus algoritmos de comprensión del lenguaje a través de Google Assistant (el asistente de Android y dispositivos como el Google Nest Hub). Por ahora, BERT solo se aplica a las búsquedas en inglés dentro de Estados Unidos, pero Google promete extenderlo a otros idiomas en el futuro, empezando por el coreano, el hindi y el portugués.